今年六月,倫敦發生恐怖攻擊。一名美國國會議員在臉書上貼文號召屠殺「激進的」「穆斯林」。

搜捕他們,確認他們身分,再把他們殺了。把他們全殺光,為了善良和正義的人們,把他們全殺光。

臉書專門負責刪除不當言論的工作人員,對希金斯暴力報復的言論,並沒有採取任何動作。

不過,在五月份,波士頓一名詩人和「黑人命也是命」(Black Lives Matter)運動人士蒂蒂德加多的貼文命運則大不相同。

所有白人都是種族主義者。你必須這個參照點出發,不然你已經先輸了。

德加多的貼文被移除,她的帳號被停用七天。

美國非營利的新聞機構ProPublica取得的臉書內部文件,揭露臉書用來區分仇恨言論與正當政治意見表達的言論的一些言論管制方針。這些文件解釋了臉書看似相互矛盾不一致的做法背後的論述邏輯。

例如希金斯煽動暴力的言詞逃過了被審查的命運,原因是在於他所針對的對象是特定的、穆斯林當中的子群組,也就是所謂「激進的」穆斯林,而德加多的貼文遭到刪除是因為她攻擊的是整體的、概述性的白人。

過去十年來,臉書已經發展出數以百計的規則,想要釐清允許張貼與否之間的界線,提供它二十億用戶一個安全的平台。近來「假新聞」的興起,許多人別有用心捏造新聞在臉書上散播,而恐怖份子也藉由這個平台招募新血,讓臉書如何審查監督它的內容的議題浮上檯面。

2010年的「阿拉伯之春」,異議人士透過臉書號召同志推翻威權政府,被形容是臉書革命。不過,從ProPublica取得的臉書文件看來,臉書對仇恨言論的管制措施中,實際上往往偏袒於菁英份子和政府,而對草根社運人士和少數族裔較為不利。當然,這種做法有助於臉書在全球的商業利益,因為它的獲利畢竟也仰賴於各國政府是否封鎖臉書在他們國家的服務。

根據這份文件,臉書內容管制的一項規則(據說如今已經廢除)是禁止「貼文讚揚使用暴力抵抗一個被國際承認國家的佔領行動」。因此,臉書的內容審查員(content reviewer),被授權刪除掉在有主權爭議地區如巴勒斯坦、喀什米爾、克里米亞以及西撒哈拉一些活動人士與記者的貼文。

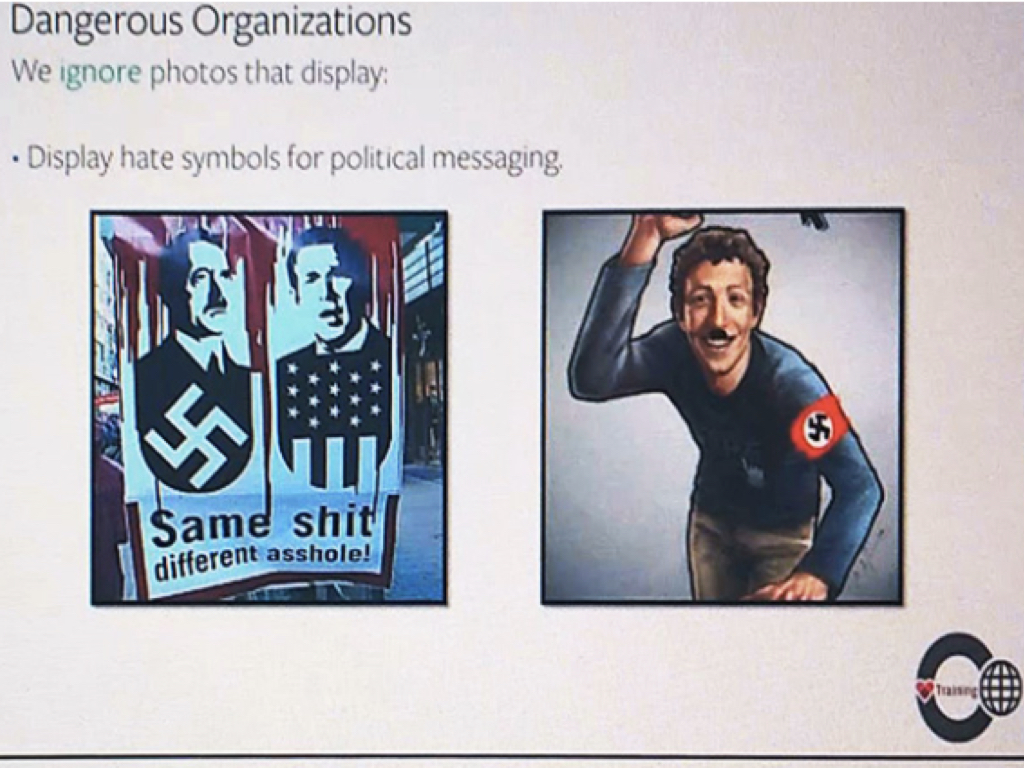

另外,內容審查員也透過訓練課程,學習運用該公司的仇恨言論演算法。比如說,在一個投影片的測驗中,題目列出了三個群體:女性駕駛、黑人兒童和白種男人。它詢問:哪一個群組受保護不被仇恨言論攻擊?

正確的答案是:白種男人。

理由在於,臉書只有在受攻擊對象是「受保護類別」時,才會刪除其不雅咒罵、抹黑、訴求暴力和其他類型的攻擊。這些受保護類別是以種族、性別、性別認同、宗教信仰、國籍、族裔、性傾向和嚴重殘疾等為判斷依據。如果攻擊的是受保護類別底下的「子群組」(subset),會則會得到臉書更寬大的待遇。白種男人被視為一個受保護的群組,因為「白種」和「男性」兩者都是受保護的,而「女性駕駛」和「黑人兒童」則和「激進穆斯林」一樣,不會被審查機制刪除,因為「駕駛」和「兒童」讓他們成了不需保護的子群組。

(詳細的規則,可以看底下ProPublica整理的投影片。)

臉書規則 :

臉書使用上面的這些規則,來訓練他們的「內容審查員」判定該刪除或保留有問題的貼文。臉書說,這些規則確切的用詞,在新版的規定中已經做過幾次的修訂。

在這套看似古怪的判別規則背後有一套更廣泛的邏輯。不同於美國的法律給予多元原則和反對歧視,而對少數種族和女性給予特別優惠待遇,臉書的演算法,在設計上對於所有種族和性別的保障一視同仁。

這種一視同仁的做法,被馬里蘭大學的法學教授席特隆(Danielle Citron)形容是「色盲」的做法,並不符合一般人認知中「公平保護」的精神。她認為這套做法「保護到的是最不需要保護的人,而剝奪了真正需要它的人」。

不過臉書說它是基於不同的目的,它希望在全球提供一致的標準。臉書全球政策管理的主管必克特(Monika Bickert)說:「(我們的)政策不必然都有最完美的結果。這是當政策應用到全球社群,而世界各地的人對於那些貼文可以分享有非常不同看法時,必須面對的現實。」

臉書的規則建構了自身的法律制度,他們和美國憲法第一修正案對言論自由的保護有著天差地遠的鮮明對比。另一方面,它也不同於歐洲對言論較嚴格的限制(例如:臉書允許否認猶太大屠殺存在的貼文)。

長期以來,臉書會移除一些明顯不當的內容,例如兒童的猥褻和色情圖片,不過審查關於表達政治立場的內容,問題則更加複雜。例如川普在競選政見中主張「禁止穆斯林移民入境美國」的貼文,就違反了臉書公司明文對「受保護群組」(穆斯林)的排他言論規定。但是在臉書創辦人祖克伯格的指示下,臉書最後並沒有對川普的貼文開刀。

近來,在一個於臉書直播的謀殺影片引發批評之後,臉書已經承諾將公司負責內容審查的人手從4500人增加至7500人。這批審核大軍可以說是負責了人類史上最大規模的全球監管作業。不過,它也可能是最不負責的,臉書並沒有公布它是如何判定哪些內容可以被允許,哪些又必須刪除。

臉書的用戶們貼文被移除時,通常沒人告訴他到底違反了什麼規定,對於臉書的決定多半也申訴無門。

從美國法律的角度來看,它並沒有要求臉書審核它的內容。對於用戶張貼的內容,依據1996年的聯邦通訊法案第230號規定,給予了臉書在內的絕大多數科技公司法律上的免責權。這項法律讓線上的出版者可以經營線上論壇,而不需在發布之前篩選檢查每一則的內容。

不過,科技公司自己很快就認知到有必要監督他們的聊天室,以防止霸凌或其他不宜內容趕跑了一般的用戶。

美國線上(America Online)一開始以免費服務為交換條件,爭取到了數千名志願者擔任它聊天室的線上警察。不過線上監督的工作越來越複雜,美國線上很快就不得不雇用正職人員全天候審查它的內容。這也是最早的「內容審查員」職務的出現。

在歐巴馬任內,成為美國第一位白宮首席隱私官(Chief Privacy Officer)的黃安娜(Nicole Wong),在2004年加入谷歌時說服公司成立了第一支審查員團隊,負責回應用戶的抱怨並回報給公司法律部門。谷歌2006年買下YouTube之後,讓判定網路內容是否適當的問題變得更加迫切。

一支嘲諷當時泰王蒲美蓬的影片引爆了爭議,最後谷歌決定封鎖這支影片,但是僅限於位址在泰國的電腦。此後,地緣封鎖(geo-blocking),也就是根據地理位置選擇性的禁播內容,成了許多政府要求的做法。黃安娜說,這並不是她所喜歡的做法,但她也承認,地緣封鎖「讓谷歌這樣的公司,得以在眾多不同的地區運作。」

不過,像臉書這種類型的社群網站,地緣封鎖可能比谷歌更加困難,因為朋友之間的內容分享會跨越國家的界線。如果臉書地緣封鎖某個人的貼文,它還是會出現在其他未禁播國家的朋友動態消息中,這也讓跨國之間朋友的對話變得複雜。

因此臉書長久以來一直盡可能避免使用地緣相關的審查規則。必克特說,臉書會考量公司運作的所在國相關法律,不過,未必會在政府的要求下移除內容。「如果有些內容違反了某個國家的法律但是並沒有違反我們臉書的標準,我們會看提出請求的是誰:它是否是政府的相關單位?然後我們會查看它是否確實上違反了法律。有時我們的做法是僅限在某個國家封鎖某個內容。」而臉書的目標,仍是建立全球性的規定。

必克特說:「我們希望確保人們可以進行無國界的溝通。」

參考資料:

Facebook's Secret Censorship Rules Protect White Men from Hate Speech But Not Black Children(Pro Publica)